德国AI幻觉第一案 AI需要为“说”出的每句话负责吗?

21世纪经济报道记者 王俊

德国的AI幻觉第一案正在进行中。

这是一起针对马斯克旗下AI聊天机器人Grok的诉讼,原告Campact e.V.协会指控Grok在回答用户提问时,输出了损伤自己公信力的不实答案。汉堡地方法院受理了该案,并于10月中旬公布了对Grok 的临时禁令:禁止其平台X.AI继续发布该虚假陈述。

图片来源于网络,如有侵权,请联系删除

具体的审理情况与进展细节并未公开,不过,案件受理以及“禁言”Grok的动作引起了业内的广泛关注:AI大模型需要为“说”出的每句话负责,或成为欧洲AI内容责任认定的首案。

AI的输出内容构成诽谤、造谣等侵权行为,AI公司是否需要为此买单?以及承担哪些责任?当前圈内莫衷一是,有观点认为,服务商不能完全控制AI内容生成逻辑,课以太多责任不够合理,当然也有观点认为AI公司应该承担起内容生成者、传播者的责任。

值得注意的是,21世纪经济报道记者了解到,国内已经有类似的AI内容侵权案件在审理中,最快年底将有案件宣判。届时,必定也会对AI幻觉、AI生成内容的平台责任认定带来巨大影响。

“AI公司不能对虚假内容置之不理”

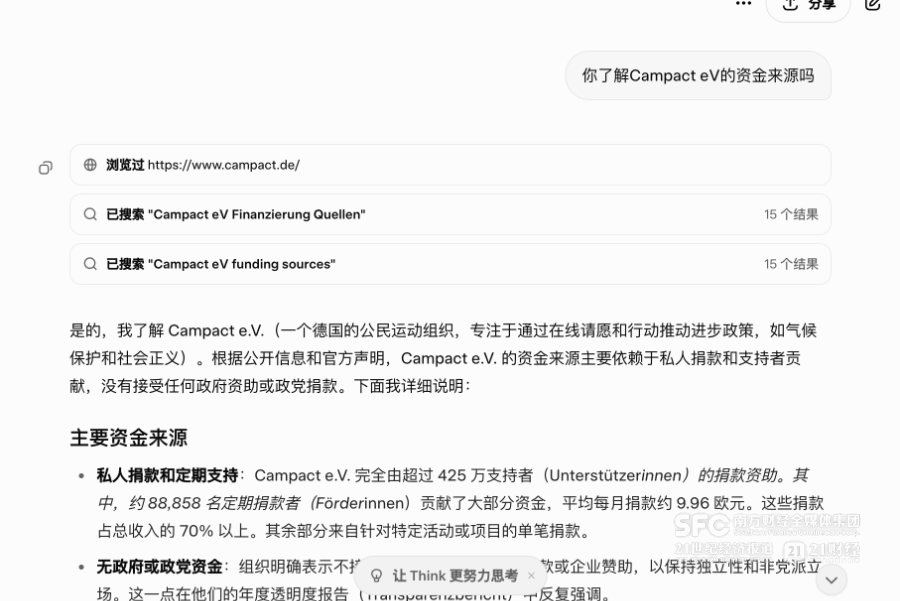

此次诉讼的起因是 Campact e.V.协会发现,在Gork在回应用户的询问时声称 ,Campact e.V.的资金来自纳税人的钱。 Campact e.V.指出这一说法是虚假的,其运营依赖于捐款。随即向汉堡地区法院提起诉讼,并针对 X.AI /Grok申请了禁令,汉堡地区法院支持了协会的要求。

它透露出了一个信号:AI公司需要为大模型生成的内容买单。

(21世纪经济报道记者尝试向grok询问资金来源)

这在国内的合规圈也荡起了涟漪。有声音指出:汉堡法院的本次禁令动作之所以在行业内引发关注,是因为它直接绕过了复杂的算法归因,将X.AI认定为虚假信息的发布者,并课以直接责任,AI需要为自己“说”的话负责。

Campact eV的经理Astrid Deilmann认为,像 Grok 这样的AI聊天机器人也有义务提供真相。 背后的X.AI 公司不能对虚假信息置之不理,必须确保谎言不被传播。

这无疑是一个很严格的要求。Campact e.V.此前一直有资金来源争议,也持续在为此进行诉讼,不过,这次的诉讼对象变成了AI。

“失实信息的出现,通常是已有失实信息广泛传播、AI算法运行原理的天然成果,又或是AI服务提供者部分识别拦截机制的不健全。”一位大厂负责内容生态的法务告诉记者。

他认为,Grok总结的内容标注了数据来源、是针对用户询问解答,沿用传统信息检索平台或新闻媒体报道的责任认定思路看,如无其他事实补充,Grok并没有生产虚假信息的主观意图、也不具有谣言的“传播扩散”事实。因此,AI生成虚假内容与AI造谣、AI诽谤并不能划等号。

天元律师事务所李昀锴指出,需要判断涉案言论内容是否有明显的侮辱、诽谤,是否存在明显失实。如果AI归纳生成的信息来源于不具有足够依据(比如采纳的是X上的某一个人账号的不具有可信度的发言),可能会存在未尽到核实责任的问题。

平台免责声明还能作数吗?

由于当前该案的裁决或详细论证尚未公布,禁令为法院的“临时命令”,因此诸多讨论尚无基石,但有一点共识:AI平台的免责声明可能不再是免死金牌。

这与此前的AI诽谤案件认定标准大不相同。2023年,美国的一名电台主持人马克·沃尔特斯 (Mark Walters) 指控OpenAI旗下的 ChatGPT 通过捏造指控和虚构诉讼诽谤自己。

相较于德国协会资金来源存在争议,马克·沃尔特斯的诽谤纯属ChatGPT瞎编。ChatGPT生成的内容显示:马克·沃尔特斯在一个案件中,涉嫌以SAF财务长的职权非法挪用基金会的资金坐上被告席。而事实是,马克·沃尔特斯亦从未任职于第二修正案基金会,也没有牵涉进入这一纠纷案件。

不过,美国佐治亚州法院最终驳回了马克·沃尔特斯的诉求,认可了OpenAI关于AI幻觉的免责声明,让其免除了诽谤责任。

法院指出:任何理性的人都不会将涉案AI生成的内容解读为真实的事实断言,尤其是考虑OpenAI 采取了广泛的措施来警告用户:ChatGPT 有时可能会生成不准确的输出。

美国对AI诽谤的认定标准,在欧洲大陆并不适用。尽管德国汉堡地区法院最终会发出什么样的审判决定还未可知,但是禁言Grok的动作一定程度上意味着对AI紧箍咒的态度。

“无论你的免责声明写得多么详实完整,AI的输出构成了法律所禁止的侵权行为(如诽谤、造谣),服务商可能就得为此买单。”李昀锴提到。

“人工智能也不能凌驾于法律之上。”Campact e.V.的经理Deilmann如此说道。

AI公司扮演何种角色?

与2023年生成式AI刚刚起步不同的是,当前的AI已经“飞入寻常百姓家”,其生成内容的影响力如同水波一样一层层荡开。

但与此相对应的,却是普遍用户AI素养断档。上海交通大学主导的“科技谣言背后的非理性群体心理与舆论生成”研究结果显示,AI早已进入了人们生活,有近半数的接受调查者经常使用大模型,但对于AI幻觉以及AI的“价值观”,大部分受调查者却没有足够的认知。

调研对象覆盖了全国31个省份的不同性别、不同年龄、不同收入层次的居民,数据显示,约七成受访者对大模型生成虚假或错误信息的风险缺乏清晰认知,高感知比例者不足一成。

在各种社交平台上,以AI生成内容作为权威的用户比比皆是,他们拿着这份未经核实的答案作为金科玉律。也正是这种笃定,衍生出了不少纠纷案件。

21世纪经济报道记者了解到,AI生成内容、AI幻觉导致的侵权、纠纷案件已经涌入国内司法领域,有的案件最快将于年底宣判。

这些案子让头部AI公司的法务头疼不已,其背后牵涉到AI公司到底应该承担何种责任,是内容生成者还是传播者?AI和传统的互联网平台有何区分?

李昀锴认为,如果相关内容是AI平台整合多个来源经过判断后归纳总结出来的内容,那这种情况下其更有可能是内容生成者,平台提供者应该有更严格的审核义务,承担的是直接侵权责任。

但上述大厂法务则指出,以Grok案件为例,不能简单将用户的询问到Grok解答的过程,理解为“平台主动发布内容”。AI服务提供者并不能完全控制内容生成逻辑,内容的生成过程中,AI解答用户问题、满足其诉求是服务的基本要求;此外,AI生成的内容,如无其他事实补充,通常不能代表AI服务提供者本身的观点与立场。

一名研究学者则认为,从该案判断,大模型肯定是内容生成者,但是否是内容传播者存疑。

他指出,尽管大模型传播了训练数据中的内容,但需要考虑非常多技术细节,特别是用户提示在生成中的贡献。此外,大模型生成内容在用户之间的传播结果不尽相同,大模型对A生成和大模型对B生成,首先AB看到内容不一定一样,其次即使一样或者相似,能不能直接推出是大模型在传播。

“AI平台的法律角色,决定其可能承担的责任义务的大小。”李昀锴指出,Grok案件或许会终结业内“模型犯错,用户负责”的商业模式。目前汉堡法院只是做出了临时禁令(仅需申请人证明侵权的初步盖然性),不是最终判决。不过,这次禁令留下一道长期的思考题:如果AI幻觉在技术上无法避免,如何设计产品的合规模型使其能最大限度上降低或免除因此产生的侵权责任?