“人类最后的考试”,中国模型赢了GPT-5

21世纪经济报道记者雷晨

图片来源于网络,如有侵权,请联系删除

近期,月之暗面三位创始人杨植麟、周昕宇和吴育昕同时现身Reddit论坛,进行了一场长达数小时的线上问答活动。

图片来源于网络,如有侵权,请联系删除

这场技术极客风格的互动,举办在Kimi K2 Thinking模型发布第五天。该模型在“人类最后的考试”等多项基准测试中表现超越GPT-5,引发全球AI社区关注。

在问答过程中,创始人团队不仅回应了训练成本、算力优化、开源策略等核心问题,更直面海外用户对“中国LLM”的使用疑虑。

多项测评成绩领先

11月6日晚,月之暗面推出Kimi K2 Thinking模型,并称其为“Kimi迄今能力最强的开源思考模型”。

这一模型基于“模型即Agent”理念训练,原生掌握“边思考、边使用工具”的能力。在多项权威基准测试中,K2 Thinking达到SOTA水平。

譬如,在被称为“人类最后的考试”的HLE(Humanity’s Last Exam)测试中,K2 Thinking获得了44.9%的成绩,超过GPT-5的41.7%。在自主网络浏览能力BrowseComp基准测试中,Kimi K2 Thinking同样以60.2%的得分,领先GPT-5的54.9%。同时在复杂信息收集推理SEAL-0测试中,其以56.3%的得分超过GPT-5的51.4%。

值得一提的是,该模型无需人类干预,即可凭借持续稳定的深度思考能力自主实现高达 300 步的工具调用,从而帮助用户解决更复杂的问题。这是月之暗面在Test-Time Scaling(测试时扩展)领域的最新进展,通过同时扩展思考 Token 和工具调用的步数,实现更强的Agent和推理性能。

K2 Thinking最引人注目的特点之一,是其推理性能的全面提升。据悉,该模型能够连续执行200至300次工具调用来解决复杂问题,保证任务连续性。

吴育昕表示,这种支持“思考-工具-思考-工具”的交错执行模式,在大语言模型中仍属较新行为。

月之暗面以HLE测试中一道人文类题目推理过程为例,在示例中,Kimi K2 Thinking经过5次搜索和推理,结合每步搜索到的新信息,层层深入,最终推理出了答案。

而当推理链条变长,如何保持其推理过程中的稳定性?杨植麟表示,团队采用端到端的智能体强化学习训练K2 Thinking,这使模型在数百个步骤的工具调用过程中,包括检索在内的每个中间环节都保持良好性能。

极致压榨算力

在算力资源相对有限的条件下,月之暗面团队展现出了优秀的工程优化能力。

吴育昕在回答中坦言,团队使用的是配备Infiniband的H800 GPU集群,无论在算力规模还是芯片性能上都不占优势。

但他强调,团队“把每张显卡的性能都压榨到了极致”。

针对训练成本问题,杨植麟也做出回应。他强调,所谓“460万美元”的成本并非官方数字,真正的训练成本很难量化,因为主要部分是研究和实验。

关于外界对模型使用较多代币的质疑,杨植麟回应道:“当前版本中,我们优先考虑的是绝对性能而非代币效率。”他表示,后续会尝试将效率纳入奖励机制,以便模型能学习如何简化思考过程。

在工程落地层面,K2 Thinking采用了原生INT4量化技术,对MoE组件应用了INT4纯权重量化,使得生成速度提升了约2倍。

周昕宇补充道,选择INT4是为了更好地兼容“非Blackwell GPU”,同时利用现有的INT4推理marlin内核。

谈及OpenAI的烧钱策略,周昕宇表示:“我们也不清楚OpenAI为何如此烧钱,这恐怕只有萨姆·奥尔特曼本人知道。我们有属于自己的方式和节奏。”

国产大模型突围

值得注意的是,月之暗面所坚持的开源策略,让中国AI大模型得到了更广泛的国际认可。

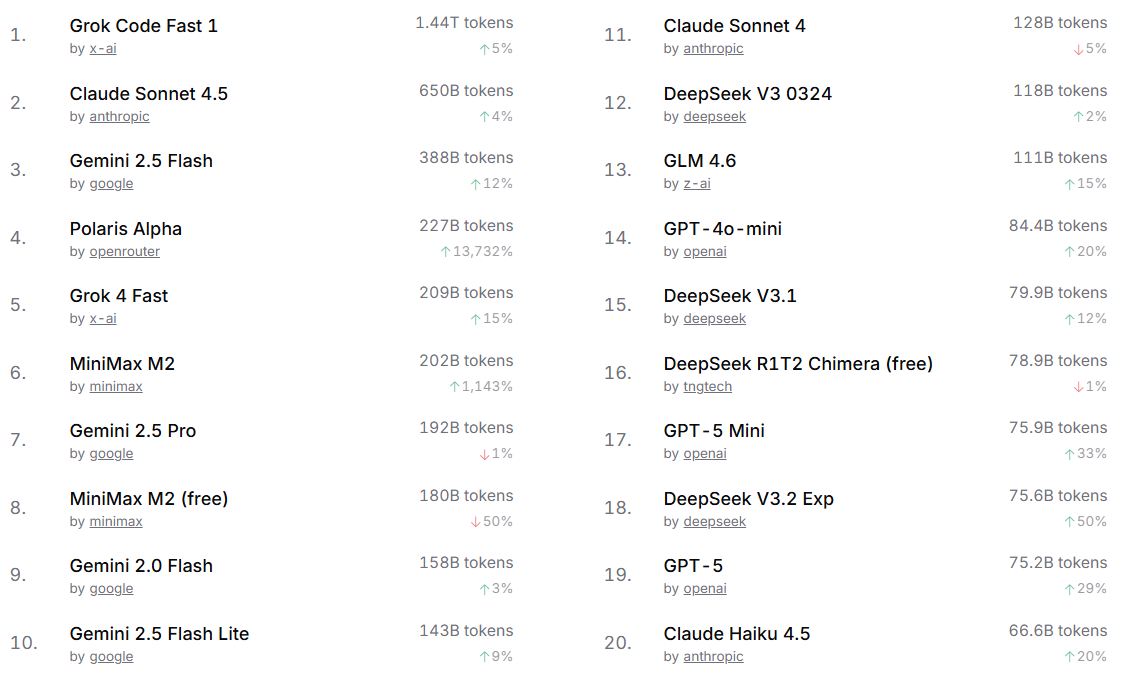

今年7月,美国知名编程工具Cursor全面禁止中国IP调用Claude等模型。市场迅速做出了选择——平台OpenRouter数据显示,Kimi K2的调用量随即大幅攀升。其API价格仅为Claude Sonnet的五分之一,展现出显著的性价比竞争力。

在交流环节,一位海外用户表示,在其工作场所,Kimi是其主要测试的模型,但生产使用上仍然会用美国本土模型,这主要由于管理层对于“中国LLM”的风险感知。

对此,吴育昕表示,虽然“封禁”风险通常超过控制范畴,但开源模式是消除部分疑虑的好办法。

杨植麟亦表示:“我们之所以支持开源,是因为我们相信开源是一件促进团结而非分裂的事情。当前虽然有一些挑战,但我们非常乐意与大家共同面对。”

从欧洲到北美,从亚洲到非洲,越来越多的开发者正在调试基于Kimi K2 Thinking的应用。

OpenRouter官网显示,在近一周的模型调用榜单上,排名前二十的模型中,中国模型已占据七席。而Kimi K2更与同期发布的Grok4登上增长榜前两名,日处理量突破100亿Token。

(图片来源:OpenRouter官网)

(图片来源:OpenRouter官网)

当前,月之暗面已经勾勒出下一代K3模型的发展蓝图。

杨植麟表示:“在OpenAI建成千亿级美元数据中心之前,K3会推出的。”他透露,团队正计划在K3中引入重大的架构变革,“KDA是我们最新的实验性架构,相关想法很可能会在K3中使用。”

据介绍,KDA(Kimi Delta Attention,一种线性注意力模块)在实验中表现出色,杨植麟表示它在所有评估维度上都展现出性能提升,包括长序列输入输出的强化学习场景,同时保持了线性注意力机制的效率优势。