专访Arm终端事业部副总裁:多端竞速,拥抱大模型创新浪潮

21世纪经济报道记者骆轶琪 北京报道

大语言模型(LLM)的快速迭代发展,正引发智能终端行业新一轮创新竞速。在此过程中,核心计算芯片产业参与者们也在蓄势。

图片来源于网络,如有侵权,请联系删除

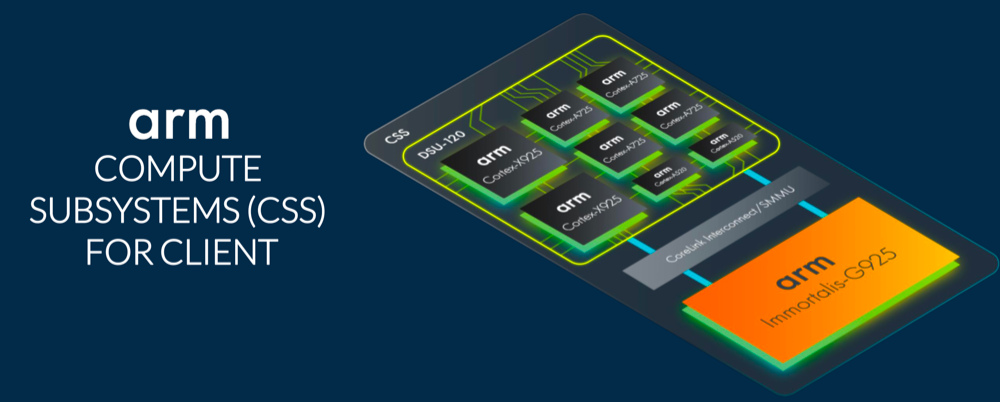

近日,Arm新推出Arm终端计算子系统 (CSS),其包括最新一代CPU和GPU硬件产品、Arm Kleidi软件库等,并能满足基于3nm工艺生产就绪的CPU和GPU物理实现。

但站在当下时点,新一轮技术浪潮仍处在初期而存在一系列不确定性,Arm终端事业部产品管理副总裁James McNiven接受21世纪经济报道记者专访时指出,“我们相信在LLM方面会持续涌现诸多创新,包括不同数据类型、多模态模型等,而这许多创新会先在CPU上运行。随着新的数据类型出现,坦白说,CPU可能是唯一能够确保运行这些创新之处。因此,我们希望能为开发者提供尽可能简单的途径。但随着技术演进,且瞬息万变,我们必须做得更多。”

(Arm终端事业部产品管理副总裁James McNiven,图源:受访者提供)

(Arm终端事业部产品管理副总裁James McNiven,图源:受访者提供)

图片来源于网络,如有侵权,请联系删除

计算加速演进

作为Arm当前的核心架构,Armv9正成为此轮AI大模型浪潮中的主要参与者。

图片来源于网络,如有侵权,请联系删除

该架构在过去几年中,多维度能力进行了显著提升:包括提高在矢量加速、机器学习 (ML) 等领域的计算能力;增强系统的安全性和稳健性;更重要的是增加了面向AI的功能。

在去年Armv9.2架构迭代的基础上,通过全新Arm Cortex-X CPU和Immortalis GPU来提供高性能。

新推出的Arm终端计算子系统(CSS)整合了最新Armv9.2 CPU和Immortalis GPU、CoreLink系统互连和系统内存管理单元 (SMMU),并优化到内存及SoC其他部分的计算路径。这也是其首次在终端领域以Arm CPU和GPU的优化设计形式,提供物理实现解决方案。

对于这里罕见提到的“物理实现”方案,James McNiven进一步介绍道,Arm的大多数IP是通过RTL(Register Transfer Level,中译为“寄存器传输级”)的形式进行交付,类似于软件形式,主要是对IP产品的描述。而要使RTL变成芯片还需要通过EDA工具流,才能把这套描述转变成实际的芯片布局。

所以“物理实现”,即Arm的设计完成了这些工具流,通过优化和工具产出物理交付。但并不是指物理的形态,它依然是近似于软件形式。

“基本上它已显示了设计中的晶体管和线路等。此外,RTL形式的IP交付依然存在,我们只是额外提供合作伙伴物理实现形式的选项,毕竟要把RTL转变为物理实现需要花费一定时间,并且需要基于对产品的全盘了解做出决策。而通过提供物理实现,我们可以帮助合作伙伴节省时间,也有助于他们实现更佳的性能和效率。”他进一步表示。

据悉,相比此前,Arm终端CSS提升了30%以上的计算和图形性能,同时提高了59%的AI推理速度。

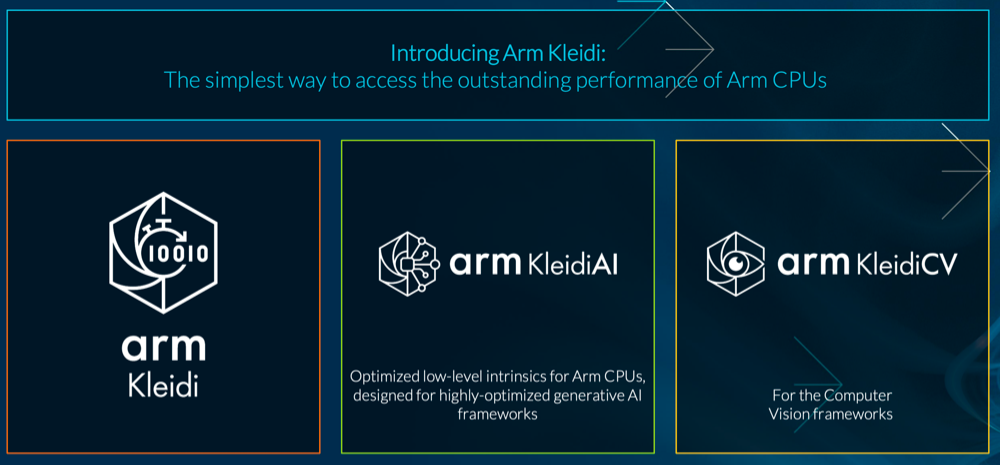

除了硬件,在软件生态方面Arm也有新动作。其同步推出Arm Kleidi,具体包括面向AI工作负载的KleidiAI和面向计算机视觉应用的KleidiCV。

(Arm Kleidi概要)

(Arm Kleidi概要)

James McNiven表示,在当今的AI和计算机视觉软件领域有诸多解决方案,但其共性在于,是为CPU构建的,且有70%的第三方安卓ML(机器学习)工作负载都在CPU上运行。因此性能越高,开发者就能越快地将功能推出。

Kleidi的作用正是如此,这些小型、高度优化的内核,旨在集成到涉及AI或计算视觉的任何地方。

举例来说,当运行于Cortex-X925上时,Kleidi技术运行最新Llama 3和Phi-3 LLM的速度要比参考实现快2.9倍,且只用不到24小时就能实现。

多终端竞速

回顾历史上的前几次新技术浪潮,发展到一定阶段后,均涌现出各种不同形态的颠覆式产品和模式创新。此轮浪潮则很大可能由AI大模型所催生,也意味着将有更丰富甚至未知的终端产品出现,目前备受关注的则是AI手机、AI PC、AR/VR等。

James McNiven对21世纪经济报道记者表示,AR和VR两者的具体计算需求也有差异。不过总体来看,Arm终端计算子系统 (CSS) 具备多款IP选项,拥有三种不同类型的CPU,且GPU核心也可从单个扩展至多个。例如Arm Immortalis-G925可配置10个以上的核心,适用于旗舰智能手机等高性能消费技术市场;Arm Mali-G725可在六至九个核心之间扩展,主要针对高端手机市场;Mali-G625可在一至五个核心之间扩展,适用于智能手表和入门级移动设备。如此便能在能效上实现更广的范围覆盖。

当然,功耗和散热对于一些可穿戴设备,如智能手表、智能眼镜乃至更为广泛的XR设备来说是一大挑战。

“因此,我们为合作伙伴提供尽可能多的选择,可以是配置一个小核CPU或者多个小核CPU,也可使用大核,甚至是Arm Cortex-X系列。”他如此表示。

在终端产品迭代过程中,其核心厂商之间也在挖掘新的成长机会。例如此前PC端应用的主流CPU产品主要来自由英特尔和AMD主导的X86架构,但Arm入局后令其在PC市场端的份额大幅提升。面向AI PC时代,新的竞争也将展开。

James McNiven对记者分析道,在此过程中,首先要确保Arm的生态系统能够交付卓越产品,如何使用户能够在基于Arm架构的AI PC或Windows on Arm (WoA) 上获得更好用户体验至关重要。同时,要支持软件生态系统,帮助合作伙伴提供最佳解决方案。无论是通过Arm架构,还是通过Arm CPU去实现更高性能和效率。

随着底层技术能力和应用诉求正快速迭代成长,这意味着计算芯片产业链上游与更多产业链角色的紧密沟通也显得重要。

James McNiven告诉记者,长期以来,Arm一直与OEM厂商(如手机厂商)、芯片合作伙伴以及代工厂合作伙伴等保持密切合作,因为这同样会影响到Arm的设计如何被置入芯片,以及该如何对其进行优化。“在软件方面也是如此,我们投入大量时间与软件相关厂商合作:最初是操作系统提供商,如来自微软或Google的安卓系统和开源社区;现在我们也与Epic Games和Unity等游戏引擎公司有更多合作;还会与LLM提供商合作,从而帮助他们更好地基于Arm架构进行优化和运行LLM。”

拥抱大模型浪潮

站在新一轮技术变革早期,其不确定性在于模型本身的技术框架依然在持续演进,相关杀手级应用更是尚未出现。这对智能终端产业链都提出新的挑战。

James McNiven告诉21世纪经济报道记者,应对方式是多方面的。首先,不论CPU还是GPU,即便有AI专用加速器,仍需要计算基础,正如CPU支撑万物。

“而如何让在Arm架构上的开发变得简单?如何让其他异构计算也能轻松集成到Arm架构上?这是我们必须要做的事。因此,作为计算基础,Arm要不断自我演进。同时,我们也要把握机会面向AI提供更多或者新的解决方案,比如面向物联网领域的Arm Ethos NPU,让我们有机会提供一款有所差异的加速模型。再者,开发者的重要性不言而喻,借助Arm Kleidi,我们确保开发者能够轻松地在Arm平台进行开发和交付。”他续称,在过往迭代中,Arm对于新兴软件的支持做了显著改变,如多年前通过Neon增加视频解码增强功能等。“我们一直在针对计算领域的新用例不断演进架构,这样的工程也持续在Armv9架构上践行。”

而伴随数字化浪潮催生出庞大的计算诉求,其对不同芯片类型的异构计算组合也提出新挑战。

(Arm终端计算子系统 (CSS)概要)

(Arm终端计算子系统 (CSS)概要)

James McNiven对记者阐释道,在GPU发展方面,从Arm Mali GPU到如今的Arm Immortalis GPU,Arm在GPU方面已经深耕多年。“首先,这是一个可扩展的解决方案,目标市场涵盖了从可穿戴设备到高端手机等。跟CPU的方式相似,我们致力于实现最佳性能和效率的平衡。”

“不仅如此,Arm还为市场带来新功能。例如2022年通过Immortalis GPU将光线追踪功能引入智能手机。”他进一步指出,“此外,我们发现根据不同用例,合作伙伴适用我们GPU的方式也不同,其中包括处理图形、推理计算。以推理为例,有些人希望在CPU上运行,因其或许希望在CPU上运行一个非常短的工作负载或LLM。但有时,有些用例在GPU或NPU上运行会更好。因此,整个异构计算也是我们采用的另一种方法。”

面对当前市面上涌现不同类型的计算芯片,James McNiven对记者坦言,Arm一直在寻找能够使异构计算更加高效的方法。“我们的确看到了多样的机会和快速变化的环境。同时,我们也持续针对互联技术进行投入,并通过标准来帮助我们的芯片合作伙伴将不同IP进行整合,例如AMBA等总线标准。这对实现差异化非常重要,也是我们的合作伙伴能够将创新扩展至其他领域,并确保在Arm平台上运行良好的关键。此外,系统内存管理单元 (SMMU) 可用于提供相同的内存视图,进而让异构计算拥有相同的虚拟内存和物理内存视图。这些功能同样能够助力异构计算。”

作为当前技术竞赛的底座,多模态大模型正持续升级迭代。James McNiven对21世纪经济报道记者分析道,Arm可以做的还有很多。“LLM在去年经常被提到,而且它们发展得相当快,通过优化可以使其大小缩减。LLM的数据类型也在不断演进,因此我们也在考虑,如何让我们的解决方案在新的数据类型和指令上能更加高效、快速。同时,我们优化CPU和GPU的实现,并针对这些用例进行优化。”

他进一步分析,“通过运行LLM,我们可以观察其运行情况,了解哪里快、哪里慢,从而对设计进行调优。大模型顾名思义可以很大,所以内存带宽也要做好准备,大量的内存流量会消耗很多能源,我们要确保IP可以高效地处理海量数据。”

此外,Arm Kleidi可为LLM开发者提供软件优化支持,“通常而言,这些开发者是各自领域的专家,比如在LLM创建和调优方面,但并不意味着他们能够充分利用硬件。所以我们投入了很多时间和资源,来帮助他们通过硬件的性能为自己的LLM开发,取得更好结果。”