攻坚AI推理赛道,高通挑战英伟达

21世纪经济报道记者 骆轶琪

图片来源于网络,如有侵权,请联系删除

高通在今年7月的第三季度财报业绩会上释放出进军数据中心市场的明确信号,如今这一规划已迅速变为现实。

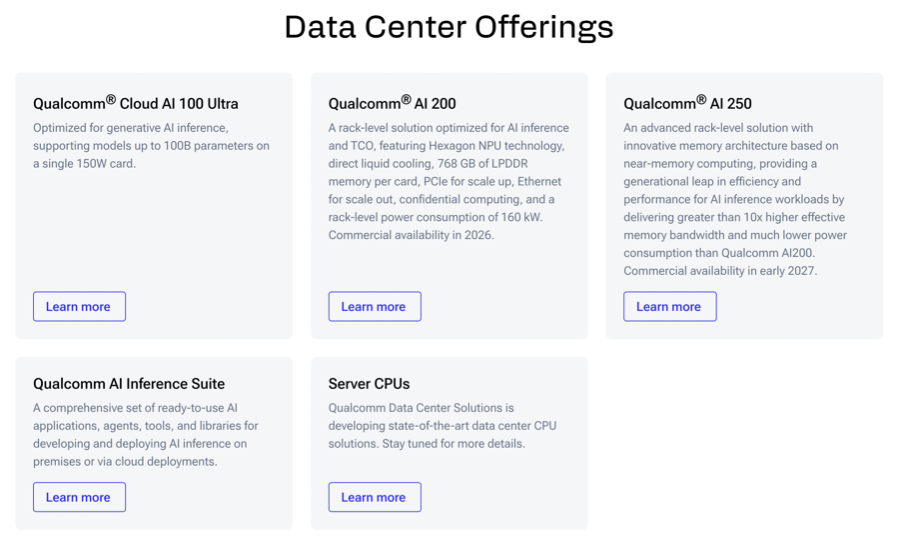

当地时间10月27日,高通宣布推出面向数据中心的下一代AI推理优化解决方案:基于Qualcomm AI200和AI250芯片的加速卡及机架级解决方案。

根据规划,AI200和AI250预计将分别于2026年和2027年实现商用。高通计划制定一个数据中心路线图,每年更新一次,专注提升AI推理方面的性能、能效和总拥有成本(TCO)。

受此消息影响,当日高通公司股价一直猛拉到20%涨幅,最终以11.09%涨幅收盘。

这其实不是高通第一次尝试挖掘数据中心市场机会,在2017年,其曾尝试推出基于Arm架构的数据中心CPU产品,但遭遇折戟。

如今看来,相比于上一次,高通通过收并购、合作等方式持续强化软硬件方面的能力,已经在数据中心领域有不同于前一次的能力储备。

当然目前在数据中心市场,新进入者面临的核心挑战之一是应用生态,高通同步公布了这批产品的第一位客户,为其对数据中心市场的再度进攻迎来良好开局。至于其未来能否取得进一步突破,则有赖于从持续完善其软硬件能力、首批落地方案的落地验证等方面共同推进。

再冲刺

根据介绍,此次推出的Qualcomm AI200是一款专用机架级AI推理解决方案,旨在为大语言模型(LLM)和多模态模型(LMM) 推理及其他AI工作负载提供低总拥有成本 (TCO) 和优化的性能。每张加速卡支持768 GB LPDDR内存。

Qualcomm AI250解决方案将首发基于近存计算(Near-Memory Computing)的内存架构,实现超过10倍的有效内存带宽和更低功耗,让AI推理工作负载效率和性能更好提升。这不仅支持解耦式AI推理,还能高效利用硬件资源,同时满足客户对性能和成本的要求。

(高通两款AI芯片产品和解决方案,图源:公司官网)

(高通两款AI芯片产品和解决方案,图源:公司官网)

据悉,两种机架解决方案均采用直接液冷散热以提高散热效率,支持PCIe进行纵向扩展、以太网进行横向扩展,并具备机密计算,以确保AI工作负载的安全性,整机架级功耗为160千瓦。

需要指出的是,不同于目前主流AI加速芯片多采用HBM(高带宽内存)的内存配置方案,高通推出的方案采用LPDDR内存,相比之下成本更低,这也与高通强调的更低TCO逻辑一致。

其实在今年7月举行的第三季度财报业绩会上,高通公司总裁兼首席执行官Cristiano Amon已经预告即将面向数据中心市场推出新产品。

彼时他指出,面向数据中心市场的扩张,是高通新的增长机遇,基于其历史上在CPU和NPU领域的沉淀,这是高通多元化战略的合理延伸。

Amon分析,随着AI推理规模的扩大,云服务提供商正在构建专用的推理集群,其同时注重性能和效率,特别是每美元的tokens数和每瓦特的tokens数;再加上市场从商用X86 CPU向定制的Arm兼容CPU转变,以及云计算等需求,为高通创造了切入点。

“我们正在打造基于NPU芯片的AI推理加速卡,并利用我们的Oryon CPU、适用于通用和AI领先节点计算解决方案的定制SoC。”他指出,此外,高通正在推进收购Alphawave IP Group plc公司一事,后者在数据中心、AI等高速有线连接方面具备优势。

根据7月份透露,高通处在数据中心市场开拓的早期阶段,正与多位潜在客户接触,与一家领先的超大规模企业进行深入洽谈。如果洽谈成功,预计将在2028财年开始产生收入。

在本次发布两款AI芯片和相关解决方案时,高通同时官宣,与HUMAIN(沙特阿拉伯一家国家级AI公司)开展合作,在沙特阿拉伯部署先进的人工智能基础设施。该计划旨在为全球提供AI推理服务,并打造全球首个全面优化的边缘到云端混合人工智能。

(高通两款AI芯片首位客户官宣,图源:公司官网)

(高通两款AI芯片首位客户官宣,图源:公司官网)

这也是两家公司在5月签署合作备忘录后的正式官宣。根据计划,HUMAIN计划自2026年起,部署200兆瓦的Qualcomm AI200和AI250机架式解决方案。

目前,在高通公司官网的“数据中心产品/服务”栏目中,已经有包括Qualcomm Cloud AI 100 Ultra、Qualcomm AI 200、Qualcomm AI 250和高通人工智能推理套件、服务器CPU五大产品矩阵。

(高通数据中心产品/服务,图源:公司官网)

(高通数据中心产品/服务,图源:公司官网)

这不是高通首次进军数据中心市场,此前高通一度有过试水,但并未取得显著成效。截至目前,数据中心业务对于高通公司来说还未在财报层面体现出明显增量。

第三季度财报显示,高通的QCT(芯片业务)部门中,手机为主的硬件(Handsets)业务(63.28亿美元)占其中收入比重的70.37%,此外贡献收入的业务包括IoT和汽车。但是从增速看,考虑到手机业务体量较大,其收入同比增速为7%,低于QCT板块整体11%的同比增速值;更是远低于IoT实现同比24%增长、汽车业务同比21%的增速表现。

在全球手机大盘没有显著增量的条件下,寻找并发力更可观的新市场就成为一个必答题。

逐渐加码

2017年8月,高通曾推出Centriq 2400,采用10nm FinFET工艺打造,是面向数据中心市场、基于Arm架构的服务器处理器。彼时高通方面称,Centriq 2400在能效和成本上比英特尔的至强Platinum 8180更优越。但很快就有市场消息显示,高通的这款产品并没有得到买账。

DIGITIMES分析师陈辰妃向21世纪经济报道记者指出,高通曾短暂挑战服务器领域,推出Centriq2400处理器,但当时服务器市场仍以英特尔(Intel) x86处理器为主,加上Arm架构在服务器市场生态尚未成熟,高通最终选择解散Falkor开发团队。

再看这一次,高通在正式进军数据中心市场之前,已经有多番布局。

2021年3月,高通宣布以14亿美元完成对Nuvia公司的收购,后者就是专注于数据中心CPU的公司。

此外,如前所述,高通还在推进对Alphawave公司的收购。在业绩会上,Amon也提到,Alphawave的高速有线连接和计算技术,对下一代定制的高通Oryon CPU以及高通Hexagon NPU处理器形成了补充。“人工智能推理的增长推动了对高通高性能、节能计算解决方案的需求,此次收购为我们拓展数据中心业务提供了关键资产。”

IPnest CEO Eric Esteve则告诉21世纪经济报道记者,Alphawave公司在高端接口IP领域处于领先地位,由于SerDes(串行器/解串器)对于构建基于以太网、PCIe、CXL或UCIe等协议构建顶级的互连能力至关重要,其可以满足构建高性能计算应用(如AI系统)的需求。

综合来看,相比几年前,高通此次再度进攻数据中心市场,在内生的数据中心所需能力方面进行了明显补全,且其采取了与市面上差异化(采用不同的内存规格选择)的发展路线。

而外部市场来看,目前业界公认,AI推理市场空间将高于AI训练市场,且在AI推理市场,已经有众多AI芯片玩家参与,包括云服务厂商自研ASIC定制芯片、新兴AI芯片公司等,都试图以不同于英伟达GPU芯片的差异化打法,挖掘增量空间。

当然,高通依然与英伟达存在密切合作。今年5月,英伟达面向定制化AI芯片市场发布NVIDIA NVLink Fusion,合作伙伴名单中,高通赫然在列。

可见,虽然此番推出AI推理芯片和解决方案,透露出高通在AI推理方面试图与英伟达竞争的野心,但其也在通过多条腿走路的方式,持续扩展生态能力。

这也是当前业界最为关注的地方,即AI芯片的落地,关键要素之一就是软件和生态能力,英伟达之所以傲视群雄,就是因为其已经花费接近20年时间搭建CUDA工具链,这是AI芯片后来者难以企及的积累。

不过好在,AI推理市场可以接纳定制化的细分需求,这也是后来者仍有发展空间的原因所在。

而高通还要面临的考验在于,其基于NPU架构打造的AI芯片和方案,落地到数据中心场景中的性能表现到底如何。因此其与HUMAIN公司打造的样板就至关重要。

Amon也在业绩会上提到,希望能借力与重要客户的合作,产生光环效应,验证产品和平台,并为未来带来新机遇。

随着高通在未来两年推进这两款数据中心产品落地,显然将为AI芯片市场带来新的火花,其在实现能力加持后能走多远,仍有待市场的持续检验。